Esparto. Dé respuestas que no son ciertas. Encuentra y lo hace con una ligereza simplemente sorprendente. Gracias a esta obvia coherencia y seguridad, las respuestas parecen ser coherentes, pero la verdad es que esto puede causar problemas inquietantes al final. Por ejemplo, recomiendan pegar la pizza para que el queso se quedara bien.

Las alucinaciones no son un error místico. En OpenAai conoces bien el problema y solo Informe analizando las causas de las alucinaciones. Según el estudio, estos resultan de la «presión estadística» en las fases de entrenamiento y evaluación.

Premio por adivinar. El problema, explica, es que en estos procedimientos es recompensado que la «presunción» en lugar de admitir que las respuestas pueden tener incertidumbre «como un estudiante tiene una pregunta difícil en un examen» y respondió algunas de las opciones disponibles para ver si es afortunado y golpea. En OpenAai, señala cómo AI hace algo similar en estos casos, y en la capacitación se alienta a responder la respuesta en lugar de responder con un simple «No sé».

Malditas probabilidades. En la fase antes de la capacitación, los modelos aprenden la distribución del lenguaje de un gran corpus de texto. Y aquí los autores enfatizan que las técnicas estadísticas que se utilizan que se utilizan el modelo, aunque los datos de origen están completamente libres de errores. La generación de un texto válido es mucho más compleja que responder una pregunta simple con un sí o no como «¿es válida esta edición?»

La predicción de la palabra tiene trampa. Aprenda los modelos de voz para «hablar» con preventivo, en los que aprenden a predecir la siguiente palabra de una frase gracias a la absorción de grandes cantidades de texto. En cada oración no hay nombres «verdaderos/incorrectos» con los que se entrene solo «ejemplos positivos (válidos) de lenguaje. Esto hace que sea más difícil evitar las alucinaciones, pero en OpenAI cree que tiene una posible respuesta que realmente ha usado en GPT-5.

Un nuevo entrenamiento. Para mitigar el problema en OpenAAI, sugiera introducir una clasificación binaria de que usted «IS-ID-Valide» (IIV «, ¿es válido?») En el que un modelo entrenado para distinguir entre respuestas válidas e incorrectas.

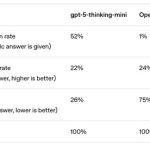

GPT-5 es un poco más modesto. Si hay una respuesta correcta, los modelos Operai clasifican las respuestas que el modelo ofrece en tres grupos: correctos, errores y abstenciones que reflejan cierta «humildad». Según sus datos, GPT-5 ha mejorado en relación con la tasa de alucinación, ya que, por ejemplo, se contienen muchos más contenidos (52%) que O4-Mini (1%) en sus pruebas. Aunque O4-Mini es un poco mejor con las respuestas correctas, es mucho peor en la tasa de error.

Los puntos de referencia recompensan los éxitos. El estudio también muestra cómo los puntos de referencia y los mapas técnicos de los modelos actuales (mapas de modelos) se concentran completamente en el éxito. De esta manera, los modelos de la IA mejoran, a pesar de que son cada vez más exitosos, y todavía hay alucinantes y casi no hay datos sobre estas tasas de alucinación, que deben ser reemplazadas por un simple «no sé».

Solución simple. Pero al igual que con las pruebas de prueba, hay una manera de evitar que los estudiantes jueguen la piscina: errores y no castigar la incertidumbre. En estos exámenes, responder desde un buen punto puede usar un punto, pero puede restar 0.5 puntos y no responder puntos. Si no sabe la respuesta, la suposición puede ser muy costosa. Bueno, con modelos de IA, lo mismo.

En | Tenemos un problema de KI: no hay una forma confiable de saber si ChatGPT es mejor que Géminis, Copilot o Claude

–

La noticia

Operai cree que ha descubierto por qué el IAS alucinado: no sabes cómo decir «no sé» debería decir.

Fue publicado originalmente en

Por Javier Pastor.